Wir sind ITGAIN.

Mit uns wird IT einfach.

Wir sind Konzeptdenker, Projektlenker und Umsetzer.

News

Pentest-as-a-Service - Sind Sie sicher?

Unklar? Deshalb jetzt mit dem automatisierten Penetrationstest in kürzester Zeit Ihre Schwachstellen erkennen.

Deine Karriere bei ITGAIN

Wir sind keine Stillsitzer. Darüber hinaus bewegen und begeistern uns Themen wie Cloud, Big Data, Sicherheit, moderne Architekturen, Managed Services, Agilität und Methodik. Dich auch? Dann freuen wir uns auf deine Bewerbung. Willkommen im Team!

Aus nächster Nähe

Darüber hinaus bieten wir dir aufregende, lehrreiche Einblicke in das IT-Beratungsgeschäft. Als immatrikulierte/r Student/in der Natur- oder Informationswissenschaften findest du bei uns nicht nur spannende Themen für Bachelor- und Masterabschlussarbeiten, sondern auch vielfältige Herausforderungen als Werkstudent/in und Praktikant/in.

Willkommen im Team!

Als Möglichmacher, Tüftler, Weiterdenker sind wir auf der Suche nach Konzeptdenker, Projektlenker und Umsetzer aus Leidenschaft: Wir laden euch ein, Teil unserer starken Mannschaft zu werden! Sei es als Anwendungs-Modernisierer, IT-Architekten, Mainframe-Migrierer oder Modernisierer. Oder vielleicht als Service-Manager, Software-Ingenieure, Datenbank-Versteher. Egal welche Rolle, ob in Hannover, Hamburg, Mannheim, Köln oder München - wir freuen uns auf euch!

Volle Kraft voraus!

Möglichmacher, die mit ihrem frisch erworbenen Abschluss durchstarten wollen, sind bei ITGAIN herzlich willkommen! Hier könnt ihr eure Leidenschaft als strategische Denker, Technologieexperten oder Engineeringspezialisten voll ausleben. Zeigt uns, was du kannst!

Produkte:

ITGAIN Trainings

IREB CPRE Foundation Training

IREB (International Requirements Engeneering Board) ist der Standard für Anforderungsmanagement. Es werden Methoden und Techniken vermittelt für die Service-, Projekt- und Produkt-Entwicklung. IREB stellt die Kommunikationsbasis für das Erstellen, Analysieren, Dokumentieren und Managen von Anforderungen bereit. In dieser Schulung lernen Sie die Notationen für Anforderungen und erhalten das notwendige Wissen des Requirements Engeneering.

Das Foundation-Level richtet sich an alle Personen, die in das Thema Requirements Engineering involviert sind.

Dazu gehören Personen in Rollen wie Requirements Engineer, Business Analyst, Systemanalytiker, Product Owner oder Produktmanager, Entwickler, Projekt- oder IT-Manager oder Domänenexperte, Softwaretester.

Von Kandidaten, die eine CPRE-Zertifizierung gemäß Lehrplan anstreben, wird erwartet, dass sie Grundkenntnisse in der Systementwicklung mit plan basierten und agilen Ansätzen haben.

IREB CPRE Requirements Elicitation

Das IREB Requirements Elicitation Modul (CPRE) vermittelt umfassende Kenntnisse und praktische Fähigkeiten zur systematischen Ermittlung von Anforderungen.

Die Schulung wendet sich an Business Analysten, Ingenieure und Manager und jeden Verantwortlichen an der Schnittstelle zwischen Menschen, die etwas benötigen und jenen, die das Benötigte erstellen. Im Zentrum steht hierbei das verbesserte gemeinsame Verständnis für das, was der Anwender benötigt.

Für die Teilnahme am Training sind keine Voraussetzungen notwendig.

Voraussetzung für die Teilnahme an der Prüfung zum CPRE Practitioner für die Module Requirements Elicitation, Requirements Management und Requirements Modeling ist der Besitz

- des Zertifikates Certified Professional for Requirements Engineering Foundation Level von IREB, welches in unserem Foundation-Training erworben werden kann,

oder

- des Zertifikates Practitioner in Requirements Engineering der British Computer Society (BCS)

Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level

Die Seminarteilnehmer erhalten eine umfassende und strukturierte Zusammenstellung der wesentlichen Testbegriffe und der testrelevanten internationalen Normen und Standards und kennen deren Bedeutung für den Testprozess. Nach dem Besuch des Seminars sind die Teilnehmer in der Lage, die behandelten Arbeitstechniken, wie z. B. die Äquivalenzklassenanalyse, auf Modul-, Integrations- oder Systemtestebene erfolgreich einzusetzen.

- System- bzw. Software-Tester

- System- bzw. Software-Entwickler

- Projektleiter und Qualitätsmanager

Dieser Kurs setzt eine Erfahrung mit softwarebasierten Systemen voraus. Erfahrungen und Kenntnisse mit Softwaretest, Systemtest sind nicht notwendig aber hilfreich.

TestLink - Open Source Testmanagement

Im Zuge der weiter steigenden Kritikalität von IT-Systemen ist auch die Bedeutung der qualitätssichernden Maßnahmen gestiegen. Ein konsequentes und durchgehendes Testmanagement, gestützt von einem Werkzeug, hilft Ihnen die Qualität von IT-Systemen kostengünstig zu erhöhen und so auch die Kosten für Implementierung und Wartung zu minimieren.

Anforderungsmanager, Testmanager, Teilprojektleiter, Tester, Software Entwickler, Scrum Master, Product Owner

Dieser Kurs setzt eine Erfahrung mit softwarebasierten Systemen voraus. Erfahrungen und Kenntnisse mit Softwaretest, Systemtest sind nicht notwendig aber hilfreich.

IREB CPRE Foundation Training

IREB (International Requirements Engeneering Board) ist der Standard für Anforderungsmanagement. Es werden Methoden und Techniken vermittelt für die Service-, Projekt- und Produkt-Entwicklung. IREB stellt die Kommunikationsbasis für das Erstellen, Analysieren, Dokumentieren und Managen von Anforderungen bereit. In dieser Schulung lernen Sie die Notationen für Anforderungen und erhalten das notwendige Wissen des Requirements Engeneering.

Das Foundation-Level richtet sich an alle Personen, die in das Thema Requirements Engineering involviert sind.

Dazu gehören Personen in Rollen wie Requirements Engineer, Business Analyst, Systemanalytiker, Product Owner oder Produktmanager, Entwickler, Projekt- oder IT-Manager oder Domänenexperte, Softwaretester.

Von Kandidaten, die eine CPRE-Zertifizierung gemäß Lehrplan anstreben, wird erwartet, dass sie Grundkenntnisse in der Systementwicklung mit plan basierten und agilen Ansätzen haben.

TestLink - Open Source Testmanagement

Im Zuge der weiter steigenden Kritikalität von IT-Systemen ist auch die Bedeutung der qualitätssichernden Maßnahmen gestiegen. Ein konsequentes und durchgehendes Testmanagement, gestützt von einem Werkzeug, hilft Ihnen die Qualität von IT-Systemen kostengünstig zu erhöhen und so auch die Kosten für Implementierung und Wartung zu minimieren.

Anforderungsmanager, Testmanager, Teilprojektleiter, Tester, Software Entwickler, Scrum Master, Product Owner

Dieser Kurs setzt eine Erfahrung mit softwarebasierten Systemen voraus. Erfahrungen und Kenntnisse mit Softwaretest, Systemtest sind nicht notwendig aber hilfreich.

IREB CPRE Foundation Training

IREB (International Requirements Engeneering Board) ist der Standard für Anforderungsmanagement. Es werden Methoden und Techniken vermittelt für die Service-, Projekt- und Produkt-Entwicklung. IREB stellt die Kommunikationsbasis für das Erstellen, Analysieren, Dokumentieren und Managen von Anforderungen bereit. In dieser Schulung lernen Sie die Notationen für Anforderungen und erhalten das notwendige Wissen des Requirements Engeneering.

Das Foundation-Level richtet sich an alle Personen, die in das Thema Requirements Engineering involviert sind.

Dazu gehören Personen in Rollen wie Requirements Engineer, Business Analyst, Systemanalytiker, Product Owner oder Produktmanager, Entwickler, Projekt- oder IT-Manager oder Domänenexperte, Softwaretester.

Von Kandidaten, die eine CPRE-Zertifizierung gemäß Lehrplan anstreben, wird erwartet, dass sie Grundkenntnisse in der Systementwicklung mit plan basierten und agilen Ansätzen haben.

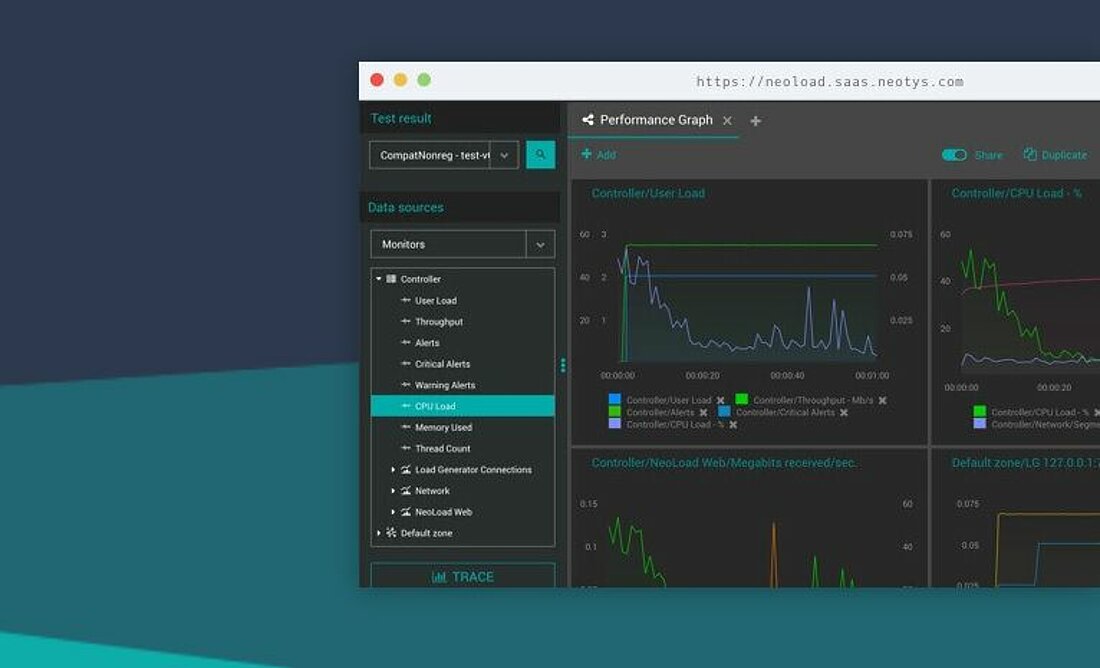

Last- und Performancetest Training

In unserem Last- und Performance Training erlangen die Seminarteilnehmer einen umfassenden Überblick über die Einsatzmöglichkeiten, von der Planung über die Spezifikation bis zur Durchführung und Protokollierung von Last- und Performancetestests unter Verwendung von „NeoLoad“. Umfangreiche praktische Erfahrungen fließen in den Lehrplan ein, um die Aufgaben in diesem Training so realitätsnah wie möglich zu gestalten. Dieser Kurs besteht sowohl aus Vorlesungen als auch aus Übungsaufgaben und Lernübungen in einer IT-Laborumgebung.

Diese Schulung ist für QA-Teammitglieder und Testingenieure, Softwareentwickler und andere Mitarbeiter geeignet, die für Last- und Leistungstests von Webanwendungen verantwortlich sind. Allgemeine Kenntnisse über Computer-, Web-, System- und Netzwerktechnologien erleichtern das Lernen.

Dieser Kurs setzt keine Erfahrung im Umgang mit NeoLoad voraus. Erfahrungen und Kenntnisse im Last- und Performancetest sind nicht notwendig aber hilfreich.

Jeder Schulungsteilnehmer benötigt einen Laptop mit installiertem NeoLoad in der aktuellen Version. Zusätzlich benötigt jeder Teilnehmer eine NeoLoad-Free-Licence für die Schulung (die Free-Licence muss bei www.neotys.com heruntergeladen werden).