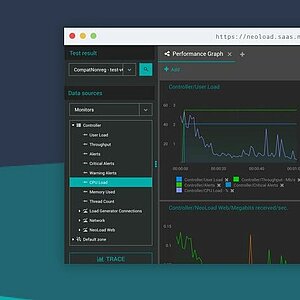

Academy Date Select Termin auf Anfrage, Testtraining Termin auf Anfrage, Unternehmerische Verantwortung Termin auf Anfrage, IREB CPRE Foundation Training 03.06.2024, Berlin, IREB CPRE Foundation Training 18.09.2024, Hannover, IREB CPRE Foundation Training 16.09.2024, Berlin, IREB CPRE Foundation Training 23.10.2024, Hannover, IREB CPRE Foundation Training 11.11.2024, Berlin, IREB CPRE Foundation Training Termin auf Anfrage, Termin auf Anfrage, Termin auf Anfrage, Termin auf Anfrage, Modellierung mit Methode – Modul: Datenmodelle verstehen 14.06.2024, Hamburg, Modellierung mit Methode – Modul: Datenmodelle verstehen 13.09.2024, Hannover, Modellierung mit Methode – Modul: Datenmodelle verstehen 15.11.2024, Hamburg, Modellierung mit Methode – Modul: Datenmodelle verstehen Termin auf Anfrage, Webseminar Exploratives Testen und TestLink – Ein Widerspruch? Termin auf Anfrage, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level 09.07.2024, Hamburg, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level 10.09.2024, Hamburg, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level 12.11.2024, Hamburg, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level Termin auf Anfrage, Snowflake-Workshop – Einstieg in die Praxis 16.07.2024, Hannover, Snowflake-Workshop – Einstieg in die Praxis 12.11.2024, Hamburg, Snowflake-Workshop – Einstieg in die Praxis Termin auf Anfrage, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 16.05.2024, Hannover, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 01.07.2024, Remote, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 01.08.2024, Hannover, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 07.11.2024, Hannover, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester Termin auf Anfrage, Workshop: Agilität in der Praxis 26.04.2024, Hamburg, Workshop: Agilität in der Praxis 17.05.2024, Hannover, Workshop: Agilität in der Praxis Termin auf Anfrage, TestLink - Open Source Testmanagement 10.05.2024, Mannheim, TestLink - Open Source Testmanagement 05.07.2024, Hamburg, TestLink - Open Source Testmanagement 12.07.2024, Hannover, TestLink - Open Source Testmanagement 19.07.2024, Mannheim, TestLink - Open Source Testmanagement 11.10.2024, Hamburg, TestLink - Open Source Testmanagement 25.10.2024, Mannheim, TestLink - Open Source Testmanagement 18.11.2024, Hannover, TestLink - Open Source Testmanagement Termin auf Anfrage, Last- und Performancetest Training 03.06.2024, Remote, Last- und Performancetest Training 23.07.2024, Hannover, Last- und Performancetest Training 08.10.2024, Hamburg, Last- und Performancetest Training Termin auf Anfrage, PostgreSQL Administrations-Grundlagenschulung 07.05.2024, Hannover, PostgreSQL Administrations-Grundlagenschulung 09.07.2024, Online, PostgreSQL Administrations-Grundlagenschulung 27.08.2024, Hannover, PostgreSQL Administrations-Grundlagenschulung 05.11.2024, Online, PostgreSQL Administrations-Grundlagenschulung Termin auf Anfrage, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 11.06.2024, Remote, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 16.07.2024, Hannover, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 13.08.2024, Remote, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 17.09.2024, Hannover, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 15.10.2024, Remote, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 12.11.2024, Hannover, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien 10.12.2024, Remote, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien Termin auf Anfrage, Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, ISO 27001 Schulung & Zertifizierung – Informationssicherheit Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, ISO 27001 Schulung & Zertifizierung – Informationssicherheit Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, PostgreSQL Administrations-Grundlagenschulung Termin auf Anfrage, Administration von MySQL / MariaDB inklusive Hochverfügbarkeitsszenarien Termin auf Anfrage, Modellierung mit Methode – Modul: Datenmodelle verstehen Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Snowflake-Workshop – Einstieg in die Praxis Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, Webseminar Exploratives Testen und TestLink – Ein Widerspruch? Termin auf Anfrage, Last- und Performancetest Training 03.06.2024, Remote, Last- und Performancetest Training 23.07.2024, Hannover, Last- und Performancetest Training 08.10.2024, Hamburg, Last- und Performancetest Training Termin auf Anfrage, TestLink - Open Source Testmanagement 05.05.2024, Hamburg, TestLink - Open Source Testmanagement 10.05.2024, Mannheim, TestLink - Open Source Testmanagement 05.07.2024, Hamburg, TestLink - Open Source Testmanagement 12.07.2024, Hannover, TestLink - Open Source Testmanagement 19.07.2024, Mannheim, TestLink - Open Source Testmanagement 11.10.2024, Hamburg, TestLink - Open Source Testmanagement 25.10.2024, Mannheim, TestLink - Open Source Testmanagement 18.11.2024, Hannover, TestLink - Open Source Testmanagement Termin auf Anfrage, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 16.05.2024, Hannover, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 01.07.2024, Remote, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 01.08.2024, Hannover, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester 07.11.2024, Hannover, Testen in agilen Projekten: ISTQB® CTFL Extension - Agile Tester Termin auf Anfrage, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level 28.05.2024, Hamburg, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level 10.09.2024, Hamburg, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level 12.11.2024, Hamburg, Testen will gelernt sein – ISTQB® Certified Tester, Foundation Level Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, IREB CPRE Foundation - Coming soon! 26.06.2024, Hannover, IREB CPRE Foundation - Coming soon! 28.08.2024, Hannover, IREB CPRE Foundation - Coming soon! 16.10.2024, Hannover, IREB CPRE Foundation - Coming soon! Termin auf Anfrage, Scrum für agile Produktentwicklung – Scrum Master und Scrum Product Owner Termin auf Anfrage, Workshop: Agilität in der Praxis Termin auf Anfrage, Workshop: Effektive Datennutzung durch die Power einer Cloud Data Platform 15.07.2024, Mannheim, Workshop: Effektive Datennutzung durch die Power einer Cloud Data Platform 11.11.2024, Hamburg, Workshop: Effektive Datennutzung durch die Power einer Cloud Data Platform